Nvidia Aduio2Face: perfektionierte Gesichtsbewegungen

Nvidia stellt seine Audio2Face-Modelle und SDKs als Open Source bereit, sodass Entwickler von Spielen und Video- und Animationssoftware realistische Charaktere mit verbesserten Lippenbewegungen und Emotionen erstellen und einsetzen können sollen.

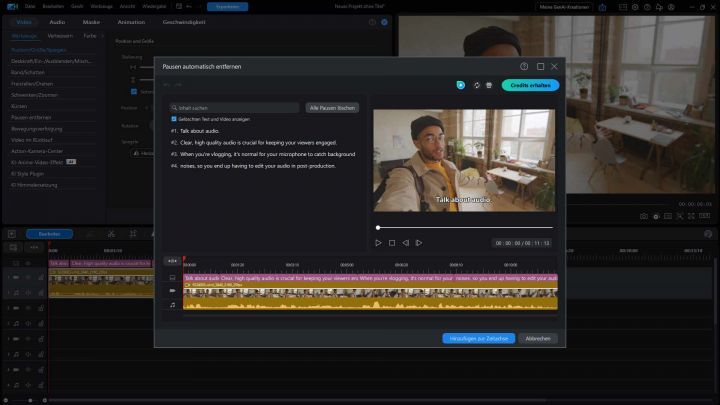

Dabei veröffentlicht Nvidia auch das Trainings-Framework für Audio2Face als Open Source, damit vorhandene Modelle für spezifische Anwendungsfälle optimiert und angepasst werden können. Audio2Face beschleunigt die Erstellung realistischer digitaler Charaktere durch Echtzeit-Gesichtsanimationen und Lippensynchronisation mithilfe generativer AI. Dabei werden akustische Merkmale wie Phonetik und Intonation analysiert, um einen Strom von Animationsdaten zu erstellen, die dann in den Gesichtsausdrücken einer Figur abgebildet werden. Diese Daten können offline für vordefinierte Inhalte gerendert oder in Echtzeit für dynamische, AI-gesteuerte NPCs gestreamt werden, wodurch Lippensynchronisation und emotionale Ausdruckskraft möglich sein sollen.

Audio2Face-Modell wird natürlich viel im Bereich Gaming eingesetzt, hat aber in Medien und Unterhaltung ebenfalls eine hohe Bedeutung. sowie Kundenservice eingesetzt. Zahlreiche ISVs (Independent Software Vendors) und Spieleentwickler nutzen Audio2Face in ihren Anwendungen. Zu den Spieleentwicklern gehören Codemasters, GSC Games World, NetEase und Perfect World Games, während zu den ISVs Convai, Inworld AI, Reallusion, Streamlabs und UneeQ zählen. Offensichtlich gehören derzeit noch keine Videotool zu den Referenzen – doch angesichts der Entwicklung rund um virtuelle Schauspieler und Moderatoren wird das eine Frage der Zeit sein.

Derzeit halten sich Emotionen dennoch sehr dezent zurück - aber man erkennt schon, dass sich eben nicht nur der Mund bewegt.

- Workshop: Automatische Bildprofil-Erkennung in Adobe Premiere Pro

- Link zum Hersteller: Nvidia

Bildquellen: Hersteller |